La industria de la tecnología se vio impactada por el regreso presencial del Consumer Electronics Show 2023, la feria de electrónica de consumo más importante del mundo. Tras un par de años de realizarse en formatos híbridos y en línea, la feria logró reunir empresas de todo el mundo bajo un mismo techo para presentar sus productos y soluciones más innovadoras hasta la fecha.

Este año, basado en el concepto de clientecentrismo, LG reveló el significado detrás de su visión ‘Life’s Good‘ al demostrar cómo sus últimos productos y tecnologías mejoran la calidad de vida y llevan la experiencia del usuario a niveles inimaginables. Al ingresar al booth de LG, los asistentes se impresionaron con el último atractivo visual OLED de la compañía, que se ha convertido en un imperdible en todos los eventos CES de la última década.

Para celebrar el décimo aniversario de LG OLED, el atractivo OLED de este año, OLED Horizon, constaba de 260 pantallas OLED flexibles de 55 pulgadas que le permitieron adquirir una forma nueva y completamente cautivadora inspirada tanto en el legado histórico revolucionario de OLED como en su futuro expansivo.

Te puede interesar:

Klaus Nomi: el alienígena de Bowie

Para recibir a los visitantes dentro del stand, la compañía colocó cuatro de las innovadoras LG SIGNATURE OLED M ensamblados a la perfección para mostrar las imágenes más fascinantes mientras parecían flotar en el aire, sin ataduras de alambres o cables. El primer televisor 4K a 120Hz del mundo con conexión AV inalámbrica, LG OLED M3 emplea una caja Zero Connect separada que permite la transmisión inalámbrica de señal de video y audio, así como conexiones a dispositivos externos, lo que ofrece a los consumidores un proceso de instalación más simple y libre al diseñar su hogar.

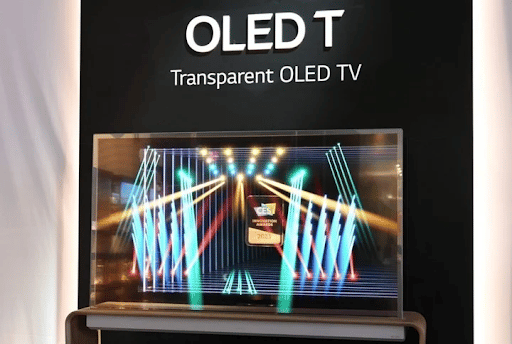

Otra gran innovación OLED mostrada en el CES este año, el LG OLED T, es tanto una obra de arte como una pantalla gracias a una hermosa combinación de cristal, madera y la revolucionaria tecnología OLED transparente. Con una conexión AV inalámbrica y la capacidad de ver a través de su pantalla de alta resolución, incluso cuando está en uso, el LG OLED T ofrece una combinación múltiple entre realidad y fantasía que armoniza el contenido en pantalla con objetos físicos o espacios para crear el contenido del futuro.

El poder de OLED tampoco se limitó a los televisores de la compañía. Equipados con el primer panel OLED de 240 Hz del mundo, los últimos monitores gaming Premium; UltraGear™ de LG, en nuevos tamaños de 27 y 45 pulgadas, ofrecen un tiempo de respuesta récord de 0.03 milisegundos. El liderazgo en tecnología OLED de LG es indiscutible, como también es el hecho de que las pantallas y televisores del futuro se llaman OLED.

“Transformación Digital”: ¡deme dos para llevar! y la cultura mexica del metate laboral… (Primera parte)

En mis 44 años de vida laboral en nuestro hermoso país he aprendido del valor cultural que poseemos.

julio 25, 2024

La tecnología digital: una herramienta para producir expresiones artísticas en el espacio público

Cuando la administración pública, de la mano de empresas creativas e innovadoras se lo proponen, pueden dar al espacio...

julio 22, 2024

La Inteligencia Artificial tiene el Potencial de Ahorrar tiempo de Trabajo

Aunque existen temores sobre su impacto en el empleo y la necesidad de supervisión humana, las ventajas que ofrece...

julio 18, 2024

Los Microplásticos, inhibidores de la erección

Es importante reducir el uso y abuso de los materiales plásticos así como encontrar las tecnologías o los métodos...

julio 18, 2024